翻了一下 Blog,上次记录开会还是 ICCV 2019。这次有超过6500人参会,虽然还不及之前 CVPR 2019,但也已经是非常大的会议了。

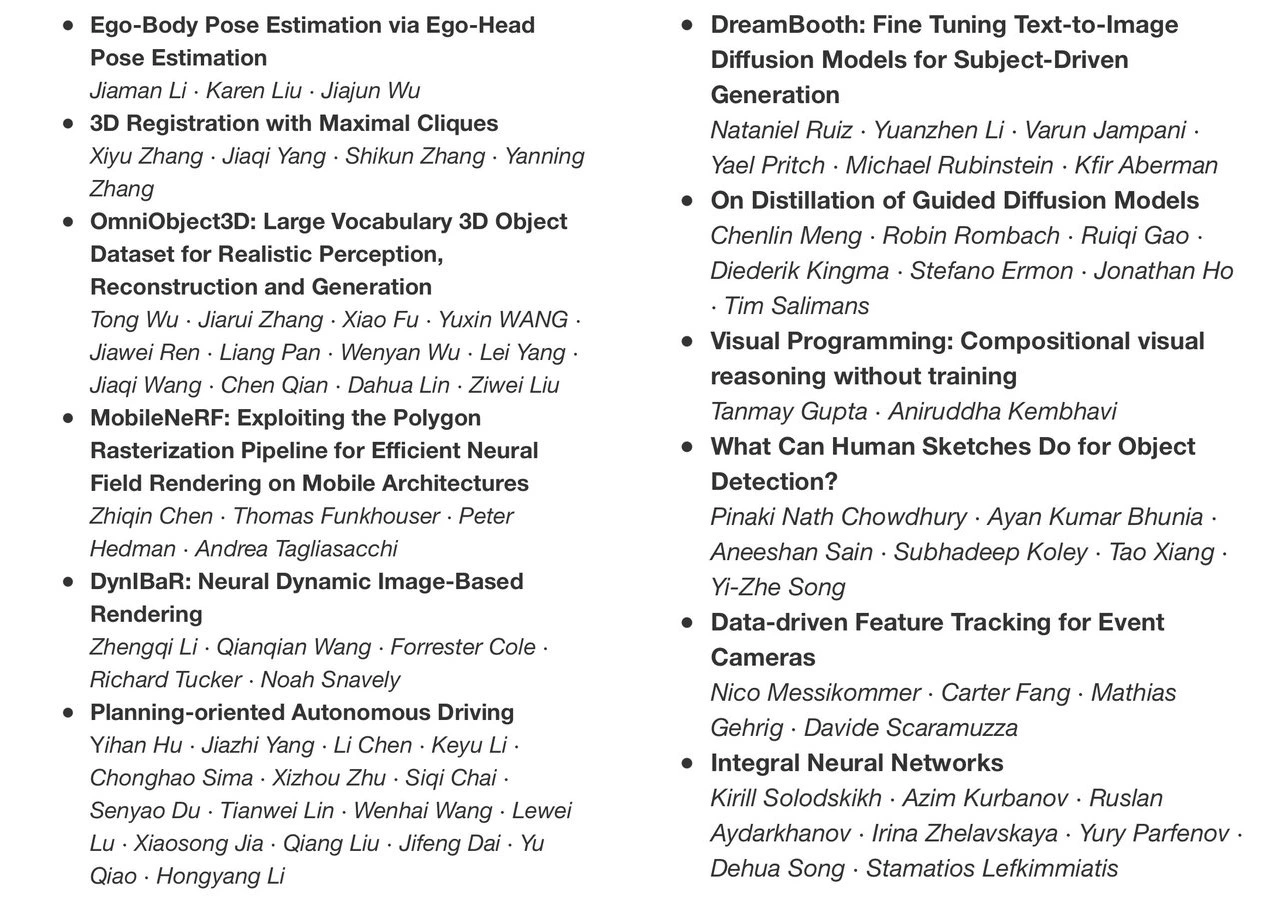

得益于 Language这边的进展,Large Language Model (LLM) 和 Visual-Language Model (VLM) 的出现改变了大家对很多问题研究的方式。比如这次 Best Paper之一的 Visual Programming,可以想象,如果没有 GPT-3 的能力,能难或者几乎不可能达到同样的效果。之前结果一直不好的 Open-World Setting,在 CLIP 的加持下,大家方法的性能也普遍得到明显提升。AIGC 毫不意外的是会上的热点,12篇 Award Candidates中,有两篇在标题上就包含 Diffusion。快速增长的领域里热点会越来越热,考虑到会议从投稿到开会的延迟,会上看到的这些都已经是半年前的工作。可想而知目前在做这些方向的人数又增加了多少。

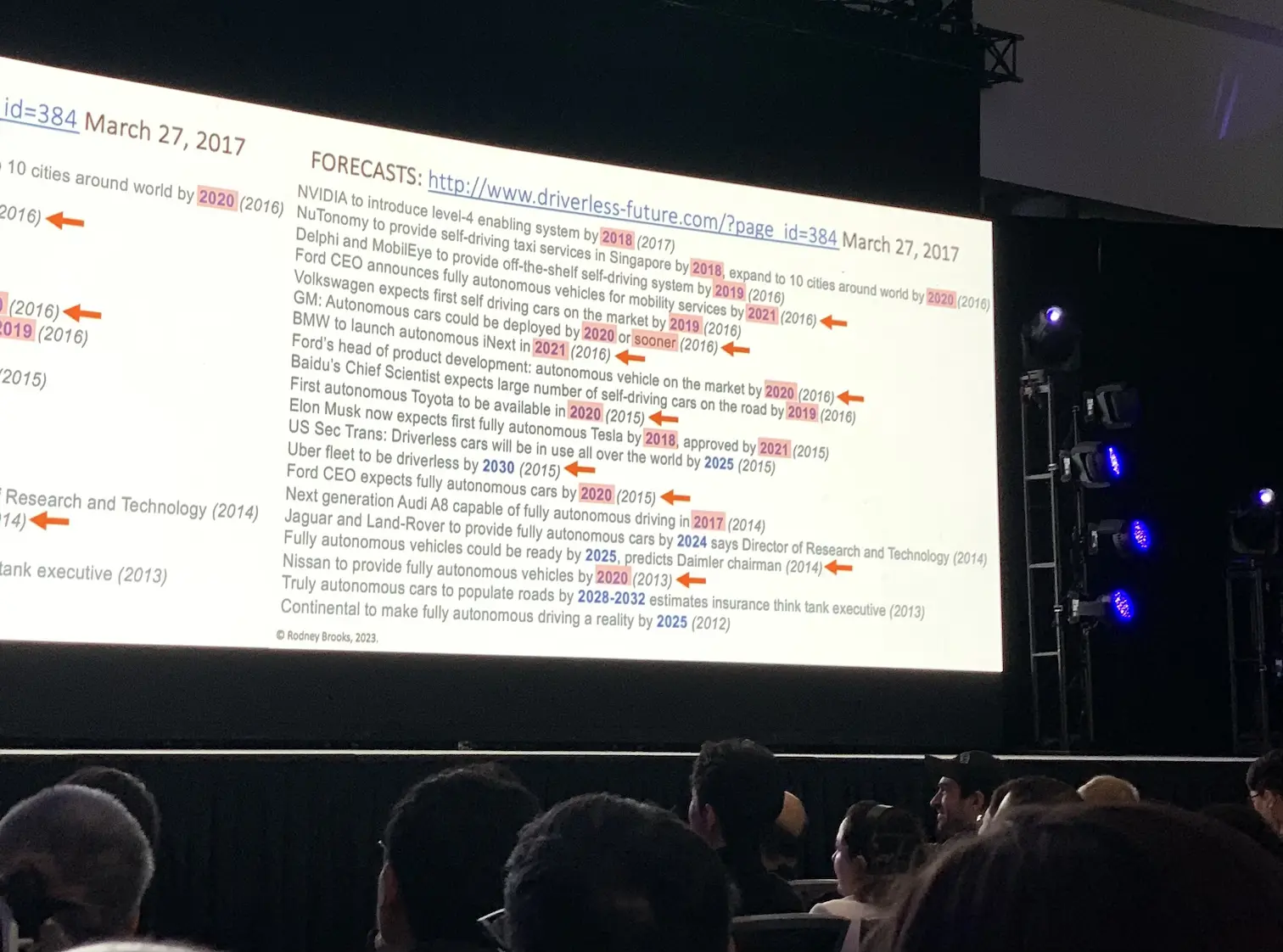

大模型和生成领域十分火热,相对而言自动驾驶方向就显得冷清了。之前的 CVPR 一度有车展的感觉,这次的车明显变少了。做自动驾驶方向的朋友也提到学生兴趣的转移。第一天的 Plenary Talk 里,Rodney Brooks 有一页 Slide 总结过去这些年大家对无人驾驶大规模部署时间的预测。总的来说,就是留给大家时间不多了 🙂

当然这个方向技术落地难度真是很大,离 L5 道阻且长。这次的另一篇 Best Paper 是自动驾驶方向的大一统模型,看起来是一个模型统一解决感知和规划的问题。研究价值自然不用说,但不太确定这在多大程度上能实际应用。

他讲的”预测AI未来的七宗罪”挺有意思的,主要的内容都在他之前的 blog post 上,值得看一看。

会议太大,尽管今年已经是 Single Track 的设置,但也只能在感兴趣的方向看一小部分的工作。每个 Poster Session 两个小时,有 400 篇文章,走马观花也看不完。大概记录一下在几个方向上粗略观察。

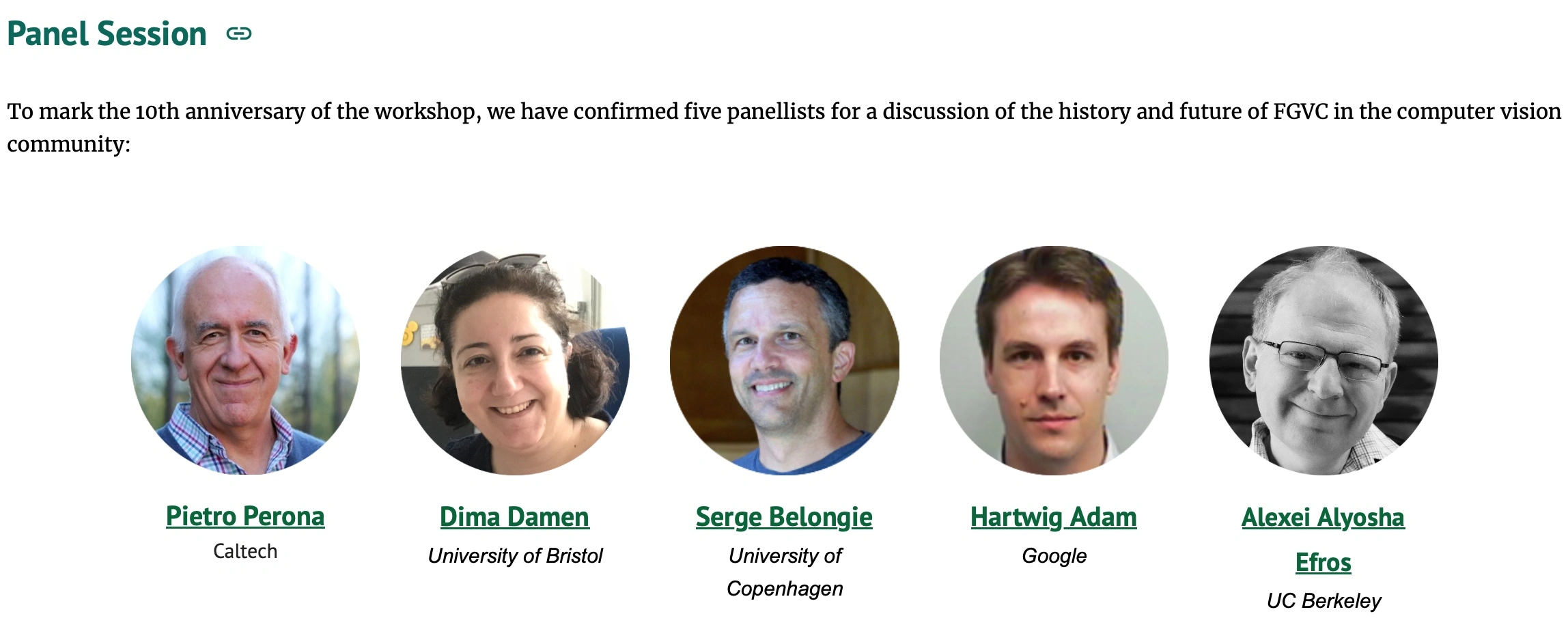

我自己一直比较关注细粒度识别这个方向。今年的 Fine-grained Visual Categorization (FGVC) Workshop 是第 10 届。组织者请了几位大佬做 Panel。因为有比较 Strong opinion 的人在 Panel 里面,这个比之后主会上的几个 Panel 更有趣。

因为大模型的出现,还有这些年 Deep Learning 的发展,大家在讨论 FGVC 这个领域何去何从。Alyosha 的观点是一切都应该是 Nearest Neighbor,每个 instance 都是一个特别的 category,categorization 这件事情本质上就是因为人脑能力有限的一种非最优的处理方式,之后可能就没有这个概念了。Serge 很强烈地反对这个观点,他认为 categorization 是很自然出现的形态,总是会存在的。两边来回辩论,很好玩。相对而言,我还是比较同意 Serge 这边,讨论中也有人提到,Nearest Neighbor 其实就是把分类用计算距离代替了,但是距离的计算依赖于一个好的特征空间,而目前的这些足够好的特征空间其实还是从细粒度标签学出来的。不过这种讨论虽然有趣,但是似乎也没有形成什么可行的方向 ¯\_(ツ)_/¯

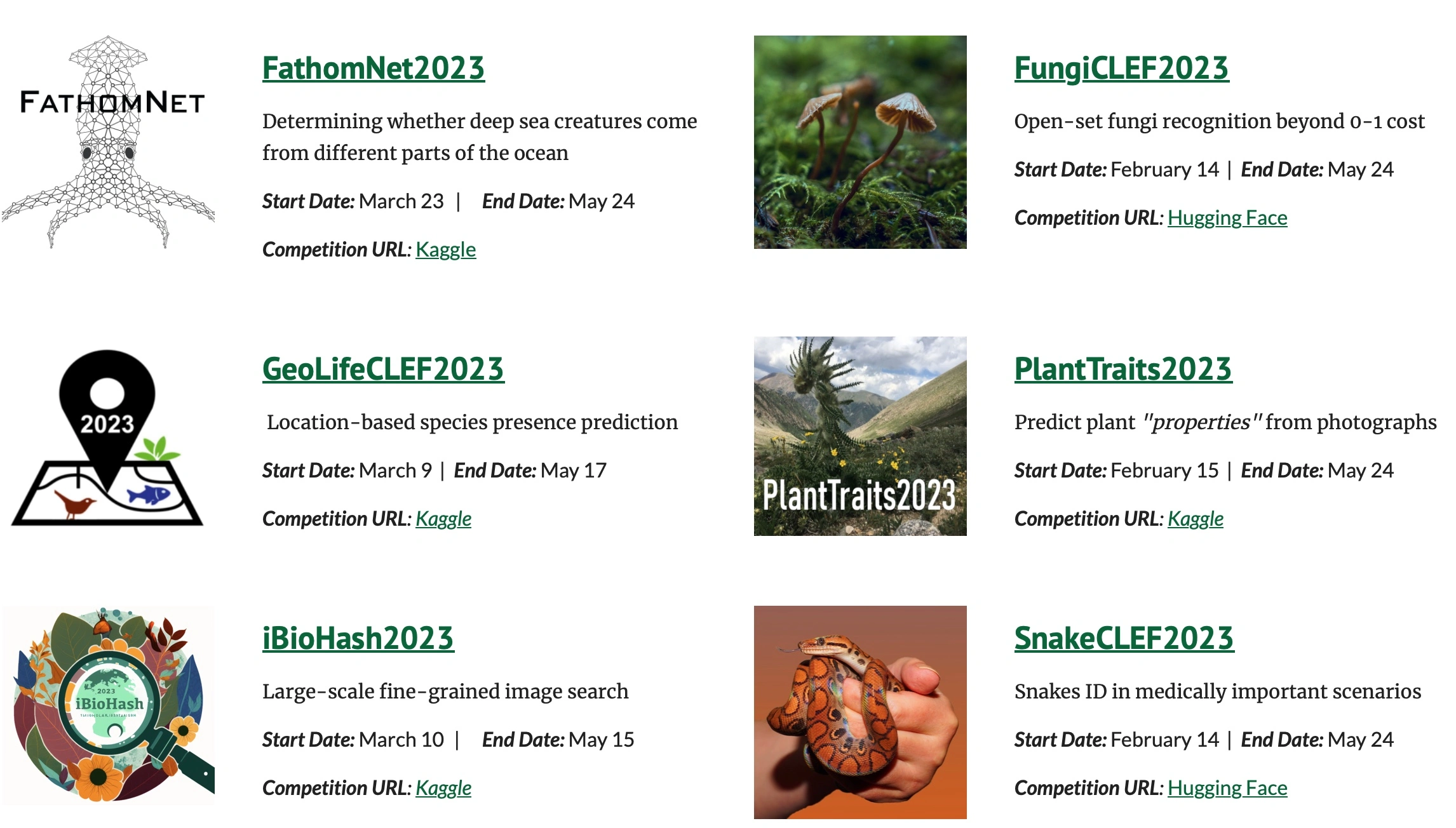

Workshop 也总结了他们最近组织的竞赛和一些组织竞赛的经验。几个竞赛提供的数据集倒是很有趣,之前大家常用的几个数据集结果都很饱和了。新的这几个看起来难度比较大,而且分类标注的质量相对也很高。后续可以关注或者尝试一下。

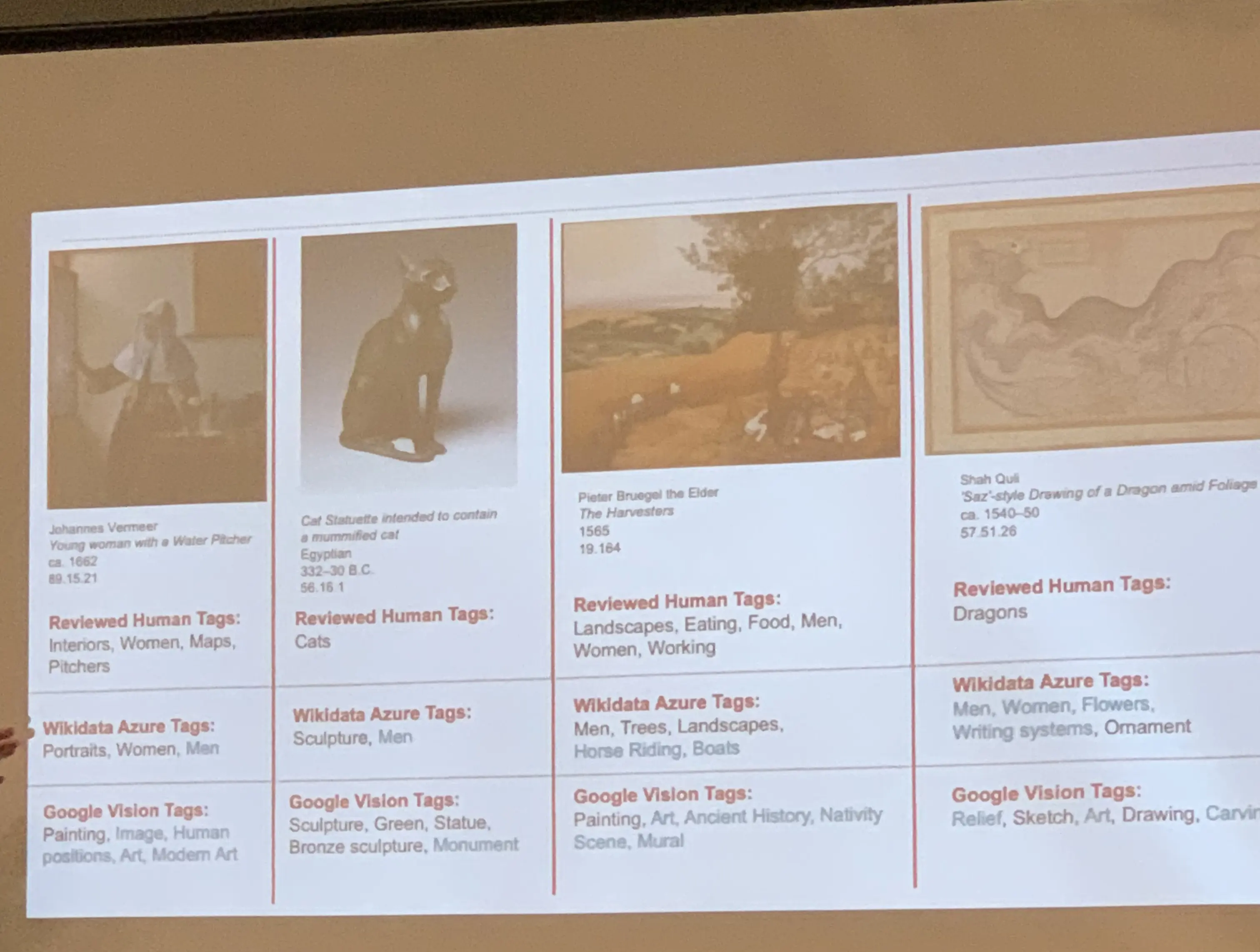

来自 The Metropolitan Museum of Art 开发部门的 Spencer Kiser 介绍了在博物馆里面做的 Image Tagging 相关的工作。技术上并没有什么特别新颖的地方,但在艺术作品范畴内怎么更好的做搜索这个问题很有趣。他说做展览策划的人员总是会说搜索不够好。从他展示的结果来看,感觉对 art 的标签可能需要重新设计,目前的标签太过于普适。

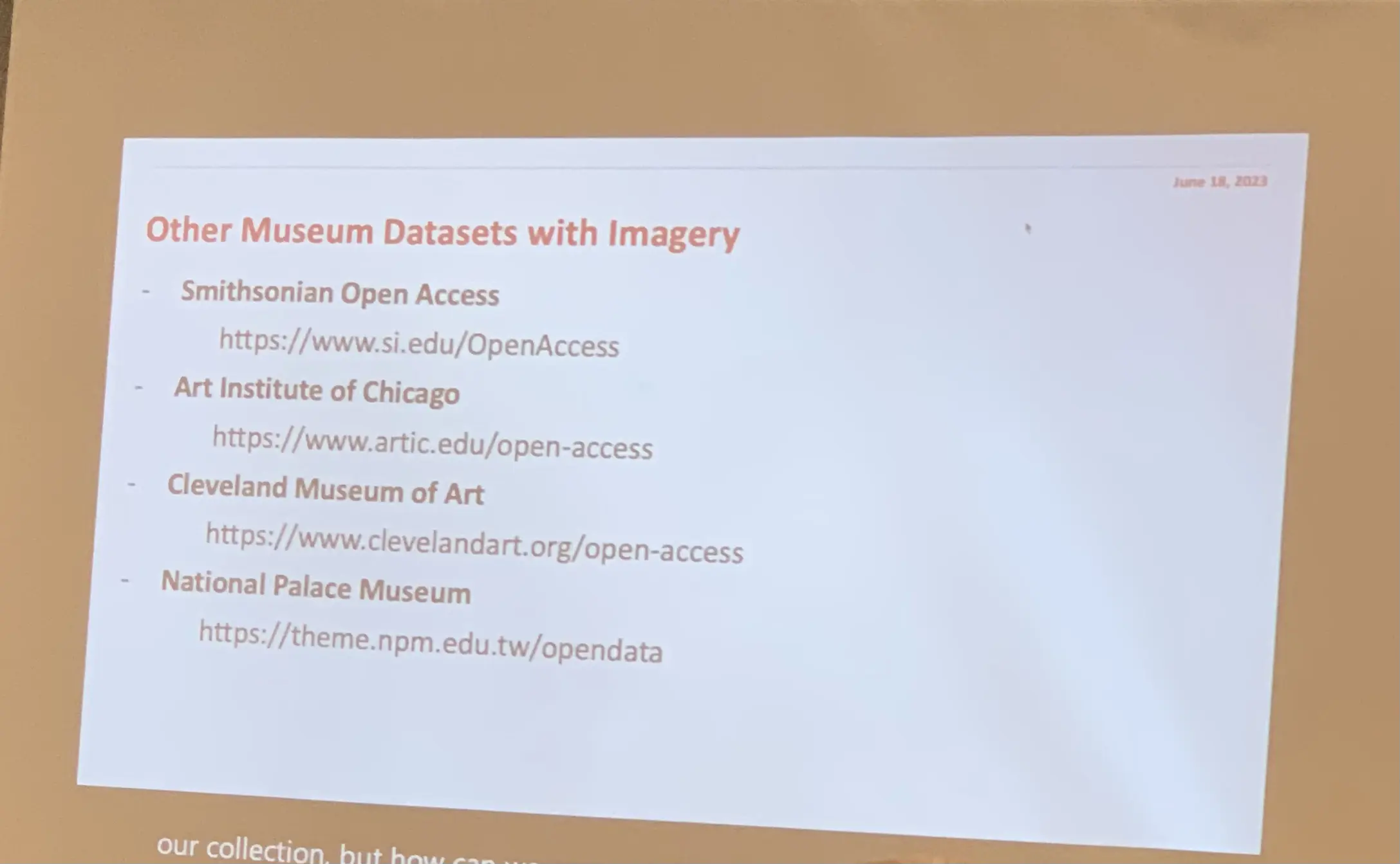

很多博物馆都有 Open access 的数据,这个很有趣,之后可以看看。

我自己的另外一个关注点是 3D 视觉。这个领域很大,这次主要听了三个和 3D Perception 相关的 Talk,分别是 Matthias Niessener, Angela Dai, 和 Georgia Gkioxari 讲的。

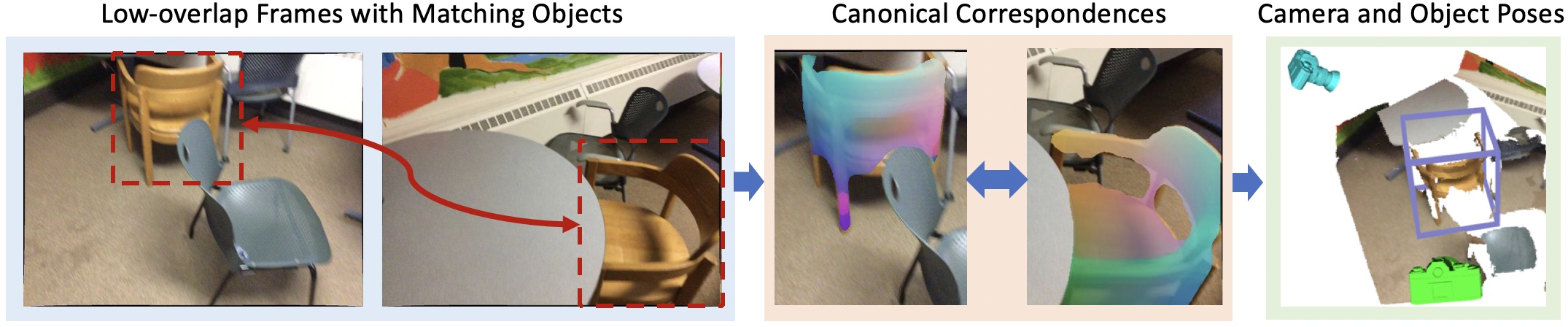

Matthias Niessener 讲了 Multi View Feature Matching, 从 VoxelHashing 到 Pri3D [ICCV 2021] 到今年的 ObjectMatch。看起来是离 Geometry 越来越远,离 Semantics 越来越近。所以在没有什么 view overlapping 的情况下,ObjectMatch 也能找到两张图直接的 Matching,虽然很酷,但从展现的方式上看,多少有点太依赖于数据了,通用性不太好判断。有点像之前做 Person Recognition,通过看后脑勺认人,虽然可以在 benchmark 上做的不错,但终究是从定义上就决定了是不可能被解决的问题。

Angela Dai 在 Structural and Compositional Learning on 3D Data Workshop 讲了一些 3D object retrieval/classification 的问题。提到了她们在做一个新的数据集ScanNet++,看起来数据质量和规模都明显提升,值得继续关注。

另外还看到了一个室内 3D 场景的数据集 HM3DSem,在之前 Matterport 扫描得到的 3D 室内环境的数据集上又增加了标注了其中的物体。这个数据集在网页上还列出来了标注的开销是14,200个小时,粗估一下也是几十万刀的投入了。

Georgia Gkioxari 主要在宣传她们组里的 Omni3D。把之前各个 3D 数据集整合起来训练了一个 3D 检测模型。这里的卖点是数据量大了之后模型的泛化能力明显变好,训练得到的模型参数也适合用来做后续小数据集上的初始化。然后后来看到还有另外一篇 OmniObject3D,提供了一个新的 Scanned Object 数据集,看起来数据质量很高。

如今 3D 数据集不但越来越多,而且大家也不是单纯在追求更大的数据集。可能是因为 Scanner 的成本降下来了,或者是 CV 这边整体投入研究的资金多了,不少数据集都在用高精度的 Scanner 在采集 3D 数据,会很有利于这个领域的发展。

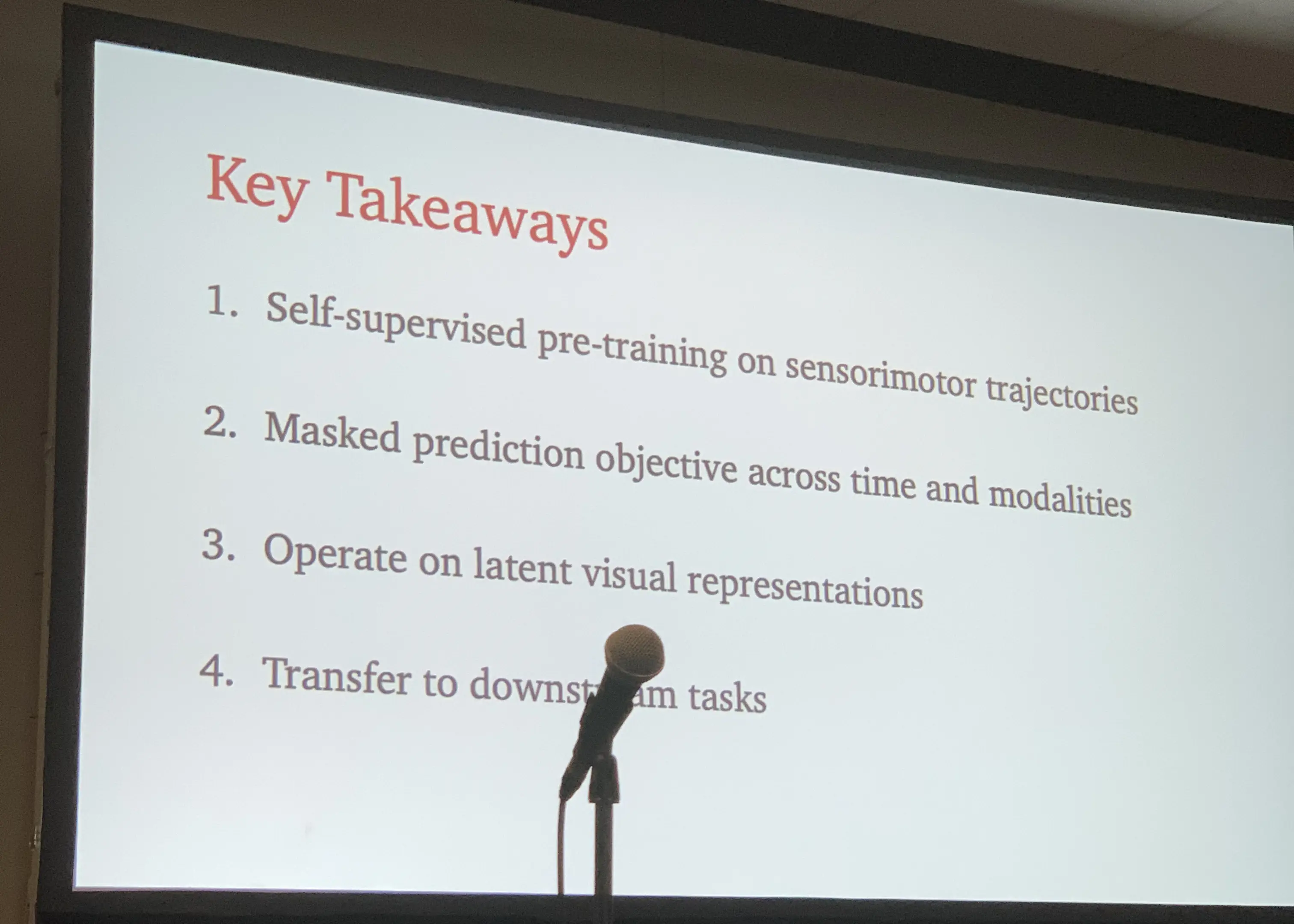

另一个感兴趣的方向是 Robotics。印象比较深的是 Prof. Jitendra Malik 在一个 Workshop 讲的 navigation 已经被解决了,接下来应该做 manipulation。然后介绍了他们组最近一些和 pre-training visual models for robot tasks 相关的工作。看起来像是说之后 Robotics 的任务也都是可以利用一个基础模型来做。不清楚在机器人的 community 是不是也有这个趋势。

还有一些看到其他工作也简单记录在这:

- Open-world object detection的工作,最近有很多,可以从这篇开始看

- https://github.com/libffcv/ffcv 一个加速训练的库

- https://nianticlabs.github.io/ace/ 非常快速的 Relocalization, Eric Brachmann 的工作,Slides 一如既往的炫酷

- https://arxiv.org/abs/2304.01042 如果需要用到 Learning-based Clustering,可以从这篇开始看

- https://arxiv.org/abs/2301.08739 加速 Transformers on Point Cloud 的算法

如今AI领域发展的很快,平时从媒体上看到都是热点,每天都有大新闻,偶尔会感觉忙乱而缺乏趣味。虽然CVPR会议越来越大,在会场不可能看完所有的内容,但逛 poster 的时候总能看到一些有趣的、之前不知道的工作,还能感受到研究的乐趣。

You must be logged in to post a comment.