Solution

Quick Solutions, iOS, Linux, C++, Matlab….

There are 78 posts filed in Solution (this is page 2 of 10).

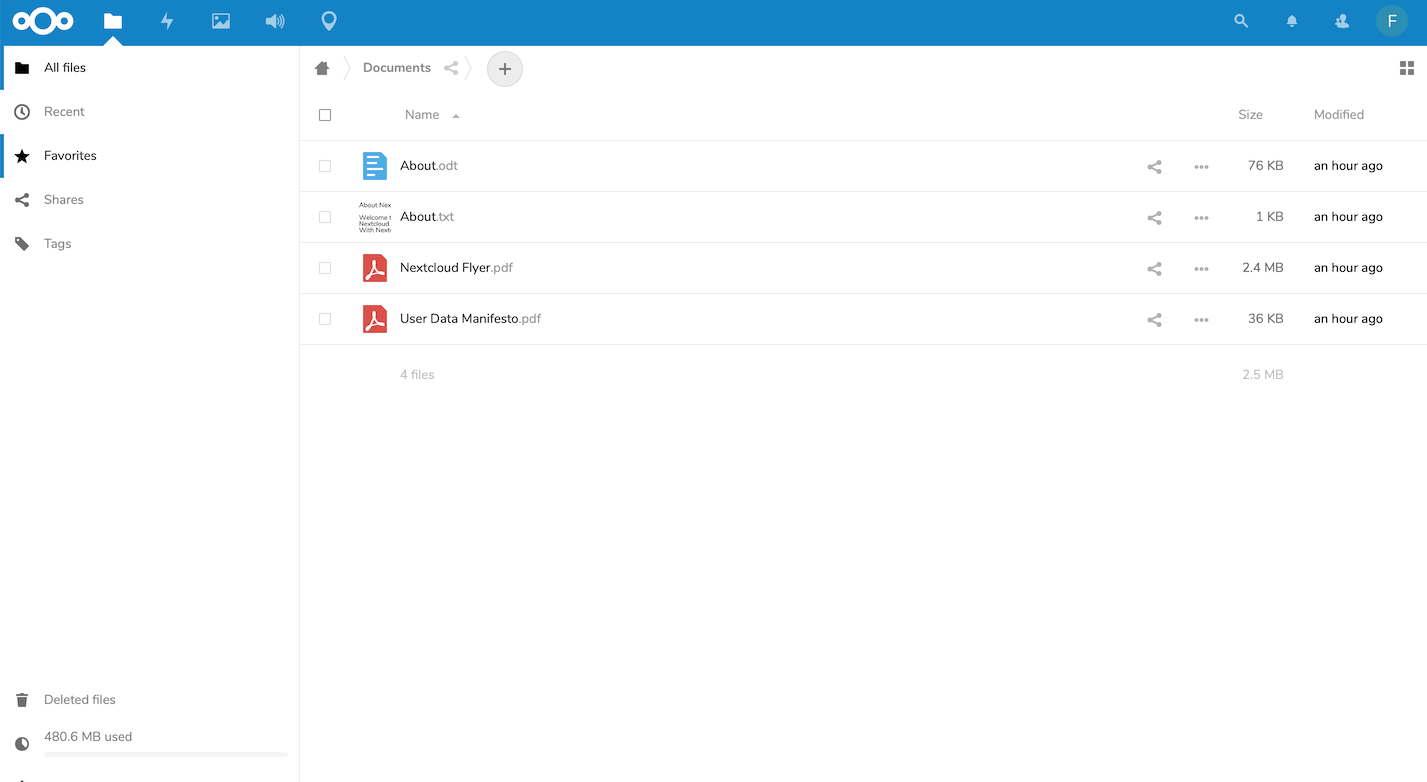

Setup NextCloud with Docker

MXNet C++ Deployment

mxnet里im2rec的坑

Crazyflie 2.0 + Camera

“Distribute” an under development app without enrolling iOS Developer Program

Build a Robot From A Power Wheelchair (1/2)

I have been working on a robotic project for a while. In this project, we build a robotic wheelchair controlled by head motions. It starts from a commercial powered wheelchair (Titan Front Wheel Drive Power Chair). We took over the control signals, added a number of sensors and wrote some computer vision softwares. It is […]